Die NVIDIA Multi-Instance GPU (MIG)-Technologie revolutioniert die Art und Weise, wie GPUs in Rechenzentren und für KI-Anwendungen genutzt werden. MIG ermöglicht es, eine einzelne GPU in bis zu sieben vollständig isolierte Instanzen zu unterteilen, wobei jede Instanz ihre eigenen dedizierten Rechenressourcen, Speicher und Cache hat. Dies garantiert eine optimale Ressourcennutzung und stellt sicher, dass Workloads effizient ausgeführt werden, ohne dass es zu Leistungseinbußen kommt. Mit MIG können Administratoren verschiedene Workloads – von kleinen Aufgaben bis hin zu großen, komplexen Anwendungen – auf einer einzigen GPU ausführen, und das mit garantierter Servicequalität (QoS).

Wie NVIDIA MIG funktioniert: Ein tiefer Einblick in die Multi-Instanz-GPU-Technologie

Die MIG-Technologie wird auf den Blackwell- und Hopper™-Architekturen von NVIDIA unterstützt und ermöglicht es, GPUs in mehrere Instanzen zu unterteilen, wobei jede Instanz ihre eigene, hochbandbreitige Speicher- und Recheneinheit besitzt. Dies stellt sicher, dass verschiedene Workloads gleichzeitig mit stabiler Leistung laufen können. Eine Instanz kann beispielsweise für KI-Inferenz verwendet werden, während eine andere Instanz für Deep-Learning-Training oder HPC-Aufgaben zuständig ist – und das alles auf derselben GPU.

Ein entscheidender Vorteil von MIG ist die Flexibilität bei der Zuweisung von Ressourcen. MIG-Instanzen können in verschiedenen Größen konfiguriert werden, um den spezifischen Anforderungen eines Workloads gerecht zu werden. Dies sorgt dafür, dass Ressourcen optimal genutzt und das Investment in Rechenzentren maximiert wird. Während des Tages können sieben kleinere MIG-Instanzen für geringere Inferenzlasten genutzt werden, während nachts dieselbe GPU für intensivere Deep-Learning-Trainingsaufgaben mit einer großen Instanz konfiguriert wird.

Schöpfen Sie die volle Leistung von NVIDIA MIG aus - sprechen Sie noch heute mit unseren Experten!

Maximieren Sie Ihre KI- und GPU-Leistung mit maßgeschneiderten Lösungen. Ganz gleich, ob Sie Ihre Infrastruktur optimieren oder Ihre Workloads skalieren müssen, unsere Spezialisten stehen Ihnen zur Seite.

Rufen Sie uns jetzt an oder füllen Sie das Formular aus, um sich von unseren Experten über die beste MIG-Konfiguration für Ihre Anforderungen beraten zu lassen. Zum Kontaktformular

Leistung in der realen Welt: Wie NVIDIA MIG Workloads transformiert

Die Leistung von MIG kann in einer Demo auf einer NVIDIA A100 Tensor Core GPU demonstriert werden, bei der sowohl AI- als auch HPC-Workloads gleichzeitig auf einer einzigen GPU ausgeführt werden. Diese Leistungsskalierung ist ein Beispiel dafür, wie MIG es ermöglicht, die GPU-Ressourcen optimal zu nutzen, indem verschiedene Instanzen gleichzeitig und isoliert arbeiten.

Steigerung der Leistung und Auslastung mit Multi-Instance-GPU

Ausführen mehrerer Workloads auf einer einzigen A100 GPU

Die wichtigsten Vorteile von NVIDIA MIG: Warum Ihre Workloads es brauchen

-

Erhöhte GPU-Ressourcennutzung: Mit MIG können bis zu sieben unabhängige Instanzen auf einer einzelnen GPU laufen, was den Zugang zu GPU-Ressourcen für mehr Benutzer und verschiedene Workloads ermöglicht. Dies führt zu einer signifikanten Steigerung der Effizienz und Flexibilität in Rechenzentren.

-

Optimierung der GPU-Auslastung: MIG gibt Administratoren die Möglichkeit, Instanzen in unterschiedlichen Größen zu konfigurieren, sodass die GPU für jede Art von Workload optimal bereitgestellt wird. Dies maximiert die Nutzung der GPU-Ressourcen und verringert Engpässe.

-

Simultanes Ausführen von gemischten Workloads: MIG ermöglicht das gleichzeitige Ausführen von KI-Inferenz, Trainings- und HPC-Workloads auf einer einzigen GPU – mit deterministischen Latenzen und Durchsatzraten. Dies unterscheidet sich von der traditionellen Zeitteilung, bei der Ressourcen zeitlich aufgeteilt werden, was oft zu suboptimaler Leistung führt.

-

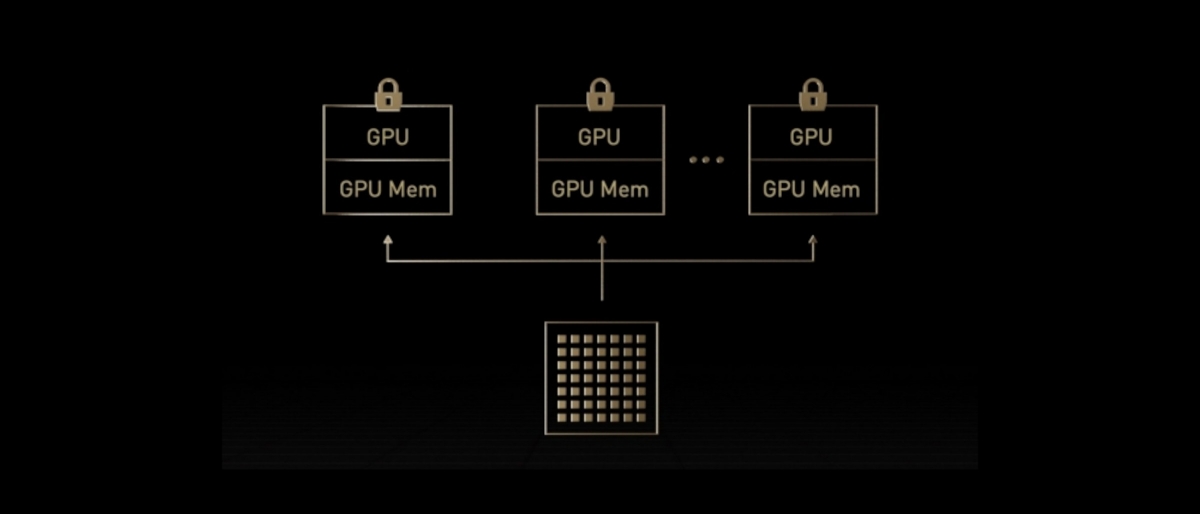

Sichere Isolierung und QoS: Jede MIG-Instanz ist vollständig isoliert, sodass Fehler in einer Instanz keine Auswirkungen auf die anderen haben. Diese Isolation garantiert eine hohe Servicequalität und Schutz der Datenintegrität.

-

Dynamische Re-Konfiguration: MIG-Instanzen können bei Bedarf neu konfiguriert werden, um sich an wechselnde Arbeitsanforderungen anzupassen. Dies ermöglicht es, die GPU-Ressourcen effizient an die unterschiedlichen Phasen eines Arbeitsprozesses anzupassen, beispielsweise indem kleinere Instanzen tagsüber und größere für rechenintensive Trainingsaufgaben nachts verwendet werden.

MIG auf NVIDIA Blackwell und Hopper GPUs

Mit der Unterstützung von MIG auf NVIDIA Blackwell- und Hopper-GPUs können bis zu sieben Instanzen gleichzeitig betrieben werden. Diese Instanzen sind vollständig voneinander isoliert, wobei jede Instanz ihre eigene dedizierte Hardware für Rechenleistung, Speicher und Cache nutzt. Dies ermöglicht es, verschiedene Workloads parallel zu verarbeiten, ohne dass sich diese gegenseitig beeinträchtigen.

-

MIG auf Blackwell GPUs: Die Blackwell-Architektur unterstützt MIG mit bis zu sieben Instanzen und bietet gleichzeitig fortschrittliche Funktionen wie Confidential Computing, um Daten sowohl im Ruhezustand als auch während der Verarbeitung zu schützen. Dies macht MIG besonders attraktiv für Forschungsumgebungen und Cloud-Anbieter, die sichere, skalierbare Lösungen benötigen.

-

Spezifikationen von MIG auf Blackwell und Hopper GPUs:

-

Auf der Blackwell-Architektur können Instanzen in unterschiedlichen Größen (bis zu 7 Instanzen mit 34 GB) konfiguriert werden. Weitere Details zur GPU-Profilierung und -Überwachung sind ebenfalls verfügbar.

-

MIG auf Hopper-GPUs bietet ähnliche Vorteile und Erweiterungen, insbesondere durch die Verbesserung der Datensicherheit und der Performance für vielseitige Workloads.

-

Anwendungsfälle aus der Praxis: Wie NVIDIA MIG KI und HPC vorantreibt

-

Forschung und Entwicklung: Forscher, die mit kleineren Workloads arbeiten, können MIG nutzen, um nur einen Teil einer GPU für ihre Aufgaben zu verwenden, ohne dass sie eine ganze Instanz mieten müssen. Dies führt zu Kosteneinsparungen und ermöglicht gleichzeitig einen sicheren Zugriff auf GPU-Ressourcen.

-

Virtualisierte Umgebungen: MIG funktioniert perfekt in virtualisierten Umgebungen, in denen mehrere Benutzer gleichzeitig GPU-Ressourcen benötigen. Dies ist besonders nützlich für Cloud-Anbieter und Unternehmen, die GPU-Server effizient betreiben möchten.

-

KI und Deep Learning: MIG ermöglicht die gleichzeitige Ausführung von KI-Inferenz und Trainingsaufgaben, wodurch Unternehmen und Forschungseinrichtungen wertvolle Zeit und Ressourcen sparen können.

Optimieren Sie Ihr Rechenzentrum - Laden Sie das kostenlose MIG-Benutzerhandbuch herunter!

MIG Spezifikationen

| MIG-Spezifikationen | Blackwell Ultra GPU | Blackwell GPU* | H100 GPU |

|---|---|---|---|

| Vertrauliches Computing | Ja | Ja | Ja |

| Instanztypen | Bis zu 7x 34GB Bis zu 4x 70GB Bis zu 2x 140GB Bis zu 1x 288GB |

Bis zu 7x 23GB Bis zu 4x 45GB Bis zu 2x 95GB Bis zu 1x 192GB |

7x 10GB 4x 20GB 2x 40GB 1x 80GB |

| GPU-Profiling und Überwachung | Parallel auf allen Instanzen | Parallel auf allen Instanzen | Parallel auf allen Instanzen |

| Gesicherte Mandanten | 7x | 7x | 7x |

| Medien-Dekodierer | Dedizierte NVJPEG- und NVDEC-Einheiten pro Instanz | Dedizierte NVJPEG- und NVDEC-Einheiten pro Instanz | Dedizierte NVJPEG- und NVDEC-Einheiten pro Instanz |

*Die angegebenen Größen für Blackwell GPUs beziehen sich auf GB200 NVL72. Die MIG-Größen für Blackwell GPUs in HGX B200 sind kleiner. Weitere Details finden Sie in der technischen Dokumentation.