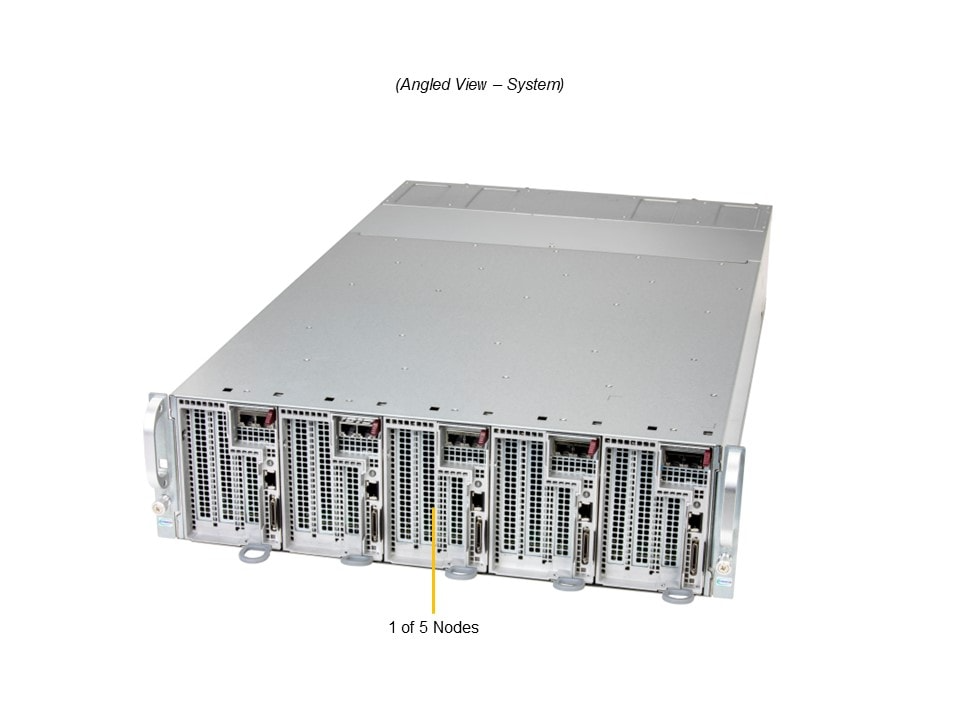

Das Supermicro AS-3015MR-H5TNR ist ein hochdichtes 3U MicroCloud System mit fünf unabhängigen Nodes in einem Chassis mit gemeinsamer Strom- und Kühl-Infrastruktur. Jeder Node unterstützt AMD-EPYC™/Ryzen™ AM5-Prozessoren, bis zu 192 GB DDR5-Speicher und optionale GPU-Beschleunigung – ideal für Cloud-Hosting, Web/Cache, CDN, Video-Streaming und GPU-beschleunigte Workloads wie generative AI, Inference/Training, Rendering und Multimedia-Workflows.

Supermicro AS-3015MR-H5TNR MicroCloud System

Key Features

- 3U 5-Node MicroCloud System mit gemeinsamer Strom- und Kühl-Infrastruktur

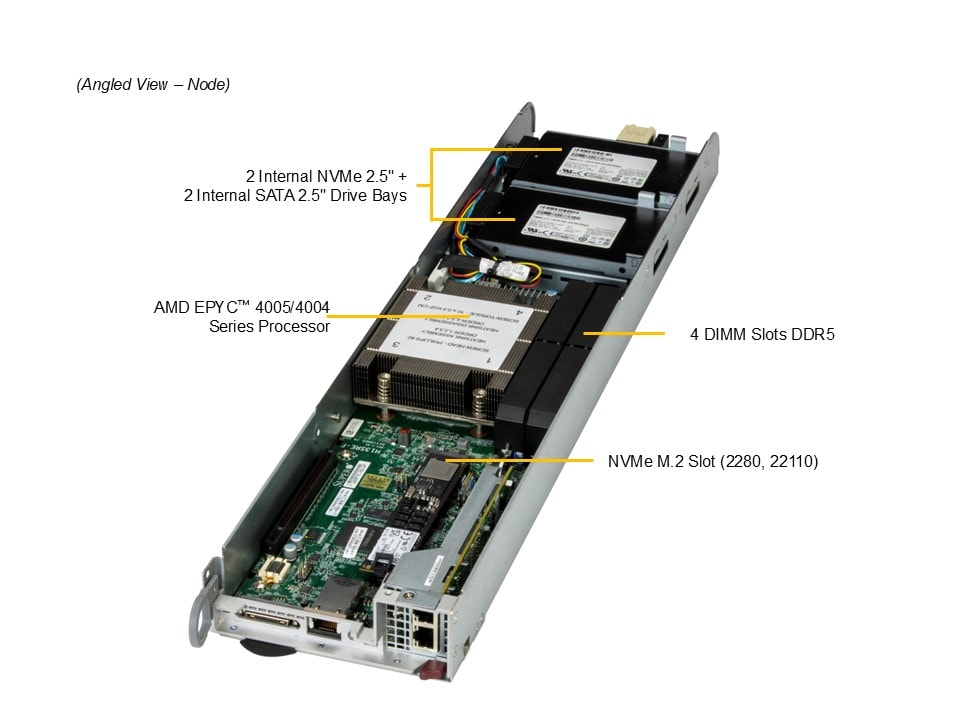

- Single-Socket AM5 (LGA-1718) pro Node: AMD EPYC 4005/4004 oder AMD Ryzen 7000/9000 Serie, bis 170 W (mit Luftkühlung)

- Bis zu 192 GB DDR5 UDIMM pro Node (ECC oder Non-ECC), 4 DIMM-Slots; bis 5600 MT/s (1DPC) / 3600 MT/s (2DPC)

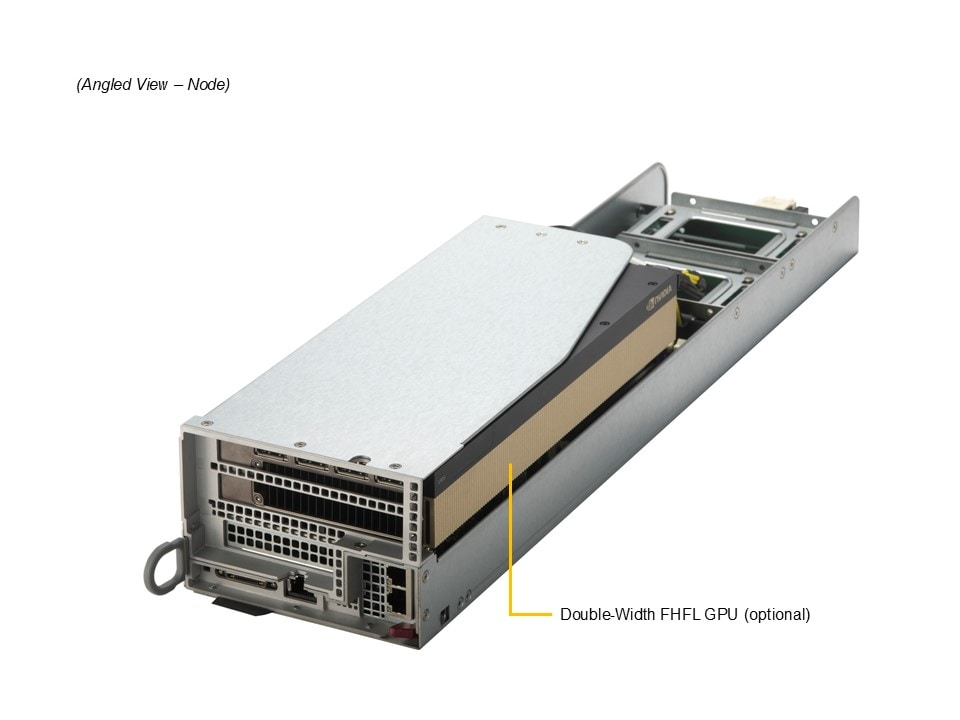

- GPU-Unterstützung pro Node: bis zu 1 PCIe GPU-Beschleunigerkarte mit doppelter Breite (Double-Width)

- PCIe 5.0 Erweiterung pro Node: Default 1 x PCIe 5.0 x16 (FHFL, Double-Width) + 1 x PCIe 5.0 x4 MicroLP

- Optionales PCIe-Layout pro Node: 2 x PCIe 5.0 x8 (1 x FHFL + 1 x LP) + 1 x PCIe 5.0 x4 MicroLP

- Storage pro Node: bis zu 2 x 2.5" NVMe + 2 x 2.5" SATA (intern, fixed) sowie 1 x M.2 NVMe (M-Key)

- Redundante, gemeinsam genutzte Netzteile: 4 x 2000 W Titanium Level

- Hohe Servicefreundlichkeit: Hot-Swap Nodes, einfache Wartung und Upgrade-Möglichkeit auf zukünftige Nodes

- Geeignet für GPU-accelerated Hosting, generative AI (Training/Inference), 3D-Grafik/Rendering, Video-Transcoding sowie Cloud- und Web-Workloads

Produktbeschreibung

Das Supermicro AS-3015MR-H5TNR ist ein kompaktes 3U MicroCloud System mit fünf unabhängigen Nodes pro Chassis und gemeinsamer Strom- und Kühl-Infrastruktur. Es richtet sich an Umgebungen, in denen viele GPU-beschleunigte Server-Instanzen mit hoher Dichte benötigt werden, ohne dabei Verfügbarkeit und Servicefreundlichkeit zu kompromittieren.

Jeder Node basiert auf einem Single-Socket AM5 Design und unterstützt AMD EPYC 4005/4004 oder AMD Ryzen 7000/9000 Serie Prozessoren sowie bis zu 192 GB DDR5 Speicher. Durch die Unterstützung einer Double-Width GPU pro Node sowie PCIe 5.0 Konnektivität eignet sich das System besonders für generative AI, Inference und Training, 3D Rendering, Video-Transcoding und weitere GPU-intensive Workloads. Hot-swappable Nodes vereinfachen Wartung und Upgrades, während redundante Titanium-Level Netzteile die Betriebssicherheit und Energieeffizienz unterstützen.

Konfigurationsmöglichkeiten

Das AS-3015MR-H5TNR lässt sich je Node in einer breiten Spanne konfigurieren – von effizienten Konfigurationen für Web-, Cache- und CDN-Workloads bis hin zu GPU-beschleunigten Setups für AI- und Rendering-Anwendungen.

- CPU (pro Node): AMD EPYC 4005/4004 oder AMD Ryzen 7000/9000 Serie, Single-Socket AM5 (LGA-1718), bis 170 W (Luftkühlung)

- Arbeitsspeicher (pro Node): 32 GB bis 192 GB DDR5 UDIMM, ECC/Non-ECC; bis 5600 MT/s (1DPC) / 3600 MT/s (2DPC)

- GPU (pro Node): Von keiner GPU bis zu 1 Double-Width PCIe GPU-Beschleunigerkarte

- Storage (pro Node): Bis zu 2 x 2.5" NVMe + 2 x 2.5" SATA (intern) sowie 1 x M.2 NVMe

- Erweiterung (pro Node): Default 1 x PCIe 5.0 x16 (FHFL) + 1 x PCIe 5.0 x4 MicroLP; optional 2 x PCIe 5.0 x8 + 1 x PCIe 5.0 x4 MicroLP

Hinweis: Darüber hinaus können Systeme vollständig individuell nach Kundenanforderung konfiguriert werden – z. B. mit spezifischen GPU-Optionen, Storage-Layouts, PCIe-Add-ons und passender Software-/Firmware-Vorbereitung.

Technische Details (Detailed Specifications)

| Kategorie | Spezifikation |

|---|---|

| Formfaktor | 3U Rackmount MicroCloud, 5 Nodes pro Chassis |

| Gehäuse / Abmessungen | Enclosure: 449 x 131 x 775 mm (B x H x T) |

| Motherboard (pro Node) | Super H13SRE-F |

| Prozessor (pro Node) | Single Socket AM5 (LGA-1718), AMD EPYC 4005/4004 Serie oder AMD Ryzen 7000/9000 Serie; bis 170 W (mit Luftkühlung) |

| Kernanzahl (pro Node) | Bis zu 16C/32T; bis zu 128 MB Cache |

| Speicher (pro Node) | 4 DIMM-Slots; bis zu 192 GB DDR5 UDIMM ECC/Non-ECC; bis 5600 MT/s (1DPC) / 3600 MT/s (2DPC) |

| GPU-Unterstützung (pro Node) | Bis zu 1 Double-Width PCIe GPU Accelerator Card |

| Erweiterungsslots (pro Node) | Default: 1 x PCIe 5.0 x16 FHFL (Double-Width) + 1 x PCIe 5.0 x4 MicroLP Optional (Option A): 1 x PCIe 5.0 x8 FHFL + 1 x PCIe 5.0 x8 LP + 1 x PCIe 5.0 x4 MicroLP |

| Drive Bays (pro Node) | Default: Total 4 Bays 2 x interne fixed 2.5" PCIe 5.0 NVMe Bays 2 x interne fixed 2.5" SATA Bays |

| M.2 (pro Node) | 1 x M.2 NVMe Slot (M-Key, 2280/22110) |

| On-Board Devices | NVMe: NVMe (Native); Chipset: System on Chip |

| Network Connectivity | Keine onboard NIC-Option; Netzwerk über Erweiterung (MicroLP) je Node |

| I/O (pro Node) | 2 x USB 2.0 Ports; 1 x Video-Port; TPM: 1 TPM Onboard/Port 80 |

| Systemkühlung | Bis zu 5 Heavy Duty 8 cm Fans; Air Shroud: 10 Air Shrouds |

| Netzteile | 4 x 2000 W redundant (3+1), Titanium Level (96%) Shared Power Supplies |

| System BIOS | AMI BIOS, 32 MB SPI Flash EEPROM |

| Management / Software | SuperCloud Composer; Supermicro Server Manager (SSM); Supermicro Update Manager (SUM); SuperDoctor 5 (SD5); Super Diagnostics Offline (SDO); Supermicro Thin-Agent Service (TAS); SuperServer Automation Assistant (SAA) |

| Einsatzgebiete | Cloud Computing, Web/Collocation Services, Web Cache, CDN, Video Streaming, Downloads, Corporate Services sowie GPU-Workloads wie generative AI, Inference/Training, 3D Rendering und Video-Transcoding |