Unvergleichliche End-to-End-Plattform für beschleunigtes Computing

Die NVIDIA HGX™ Plattform vereint die volle Leistungsfähigkeit von NVIDIA GPUs, NVIDIA NVLink™, NVIDIA Networking sowie optimierte Software-Stacks für KI und High-Performance-Computing (HPC). Das Ergebnis ist maximale Anwendungsleistung und eine drastisch verkürzte Zeit bis zu verwertbaren Erkenntnissen – für jedes moderne Rechenzentrum.

Die NVIDIA HGX B300 integriert acht NVIDIA Blackwell Ultra GPUs mit Hochgeschwindigkeits-Interconnects und liefert 1,5-fach mehr FP4 Tensor Core FLOPS und doppelte Attention-Performance im Vergleich zur HGX B200. Damit eröffnet sie eine neue Generation von beschleunigtem Computing und generativer KI.

Als führende Scale-Up-Plattform bietet die B300 bis zu 30-fach mehr AI Factory-Output als die Vorgängergeneration und ist damit ideal für anspruchsvollste generative KI-Modelle, Data-Analytics-Workloads und HPC-Anwendungen.

KI-Leistung und Vielseitigkeit

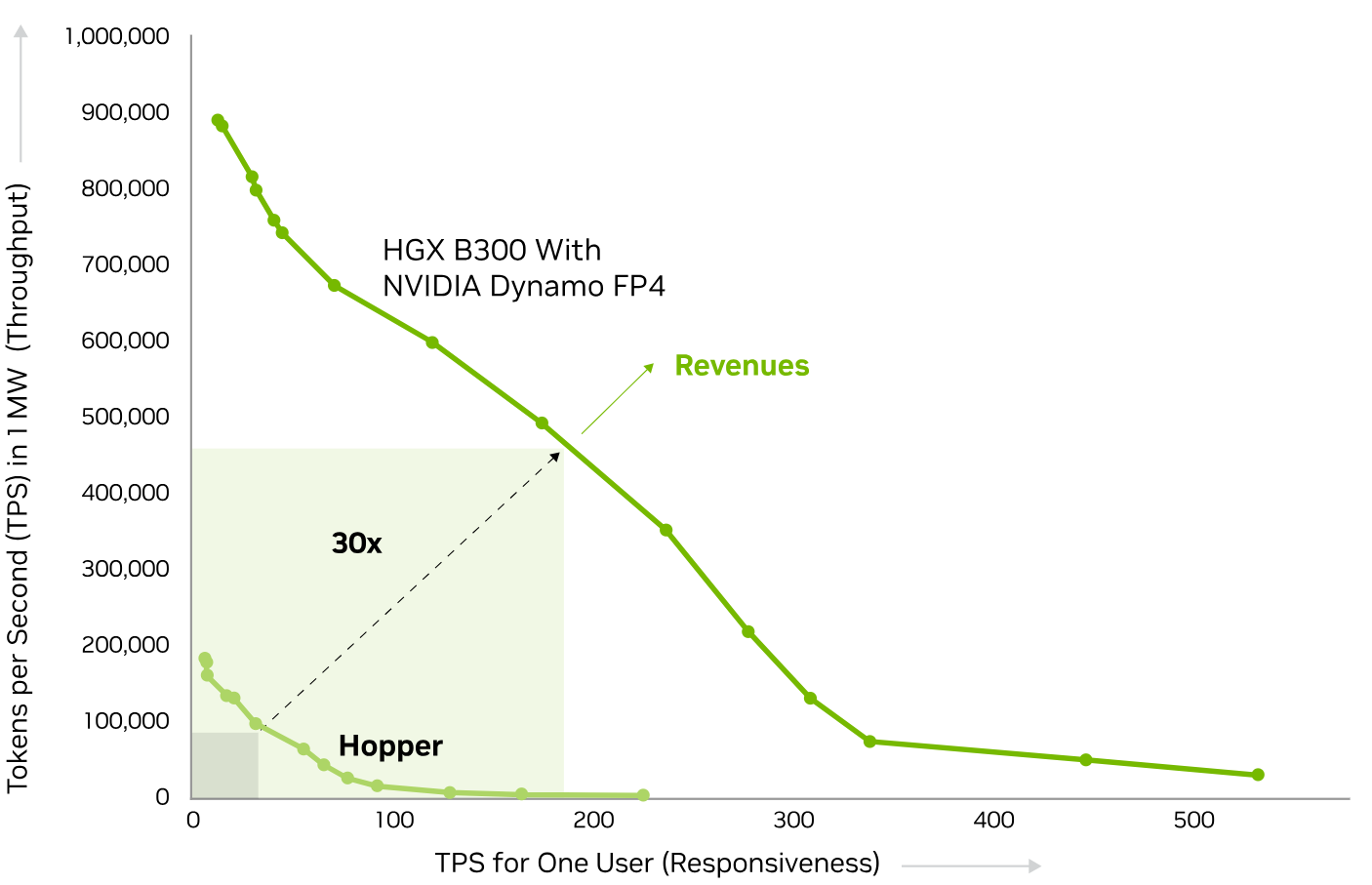

Mehr Umsatz mit HGX B300 AI Factory Output

Die Frontier-Kurve verdeutlicht die wichtigsten Parameter für den KI-Fabrik-Output. Auf der vertikalen Achse wird der GPU-Durchsatz in Tokens pro Sekunde (TPS) in einer 1 MW-AI Factory dargestellt, während die horizontale Achse die Interaktivität und Reaktionsfähigkeit für einzelne Nutzer misst.

Am optimalen Schnittpunkt von Durchsatz und Reaktionszeit erreicht die HGX B300 eine 30-fache Steigerung der AI-Factory-Leistung im Vergleich zur NVIDIA Hopper-Architektur – für maximalen Token-Ertrag und höhere Umsätze.

Skalierbares Training für große KI-Modelle

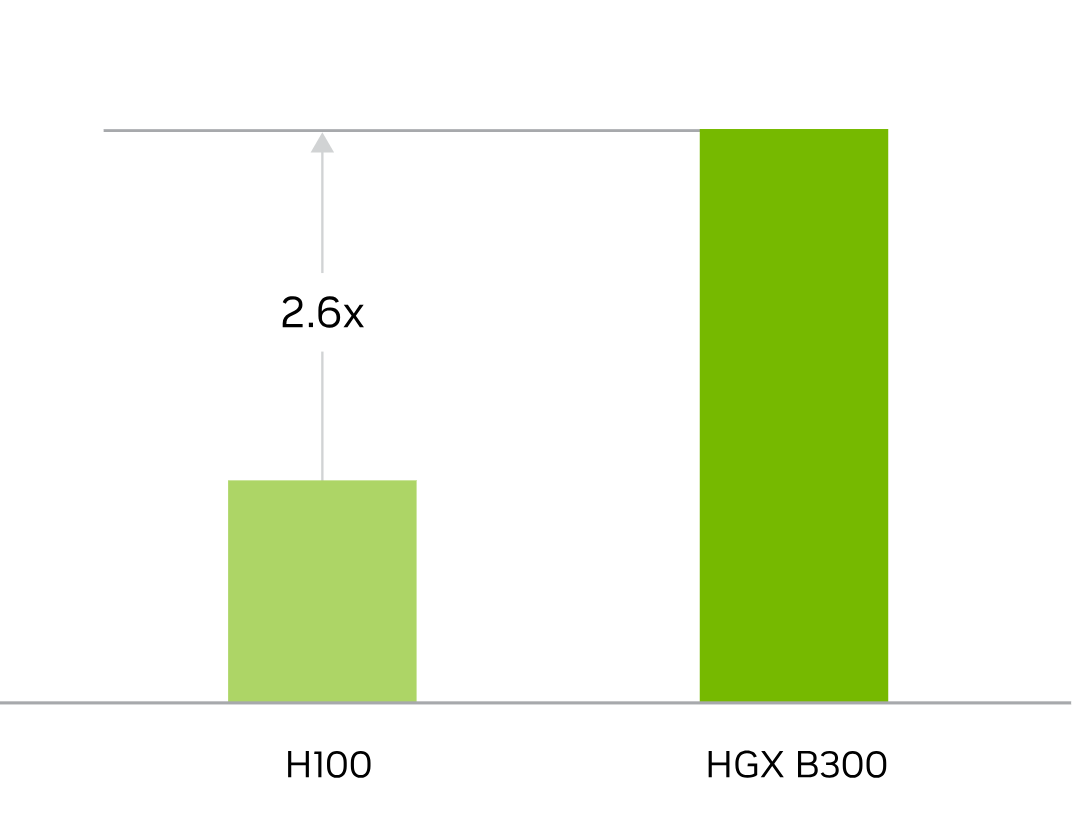

2,6-fach höhere Trainingsleistung mit DeepSeek-R1

Die HGX B300 liefert bis zu 2,6-fach höhere Trainingsleistung für große Sprachmodelle wie DeepSeek-R1 (Leistungswerte pro GPU, FP8, Batch Size 16K, Sequenzlänge 16K – Projektionen vorbehaltlich Änderung).

Mit über 2 TB Hochgeschwindigkeitsspeicher und 14,4 TB/s NVLink Switch-Bandbreite ermöglicht die Plattform Training im massiven Maßstab sowie eine hocheffiziente Kommunikation zwischen den GPUs.

Beschleunigung durch NVIDIA Networking

Das Rechenzentrum ist heute die neue Recheneinheit – und das Netzwerk spielt eine zentrale Rolle beim Skalieren der Anwendungsleistung.

Mit NVIDIA Quantum InfiniBand liefert HGX Weltklasse-Performance und maximale Ressourcenauslastung.

Für KI-Cloud-Rechenzentren mit Ethernet-Infrastruktur empfiehlt sich NVIDIA Spectrum-X: Diese Plattform bietet die höchste KI-Leistung über Ethernet, durch Spectrum-X-Switches und NVIDIA SuperNIC. Das Ergebnis: optimale Ressourcennutzung, Performance-Isolation und vorhersehbare Ergebnisse selbst bei Tausenden paralleler KI-Jobs.

Spectrum-X ermöglicht zudem fortschrittliche Multi-Tenancy und Zero-Trust-Sicherheit.

Ein Referenzdesign ist Israel-1, ein Hyperscale-Supercomputer für generative KI, aufgebaut mit Dell PowerEdge XE9680 Servern, basierend auf der NVIDIA HGX 8-GPU-Plattform, BlueField-3 SuperNICs und Spectrum-4 Switches.

NVIDIA HGX Spezifikationen

Die NVIDIA HGX-Plattform ist in Konfigurationen mit vier oder acht Hopper-SXMs sowie mit acht NVIDIA Blackwell- oder Blackwell Ultra-SXMs erhältlich. Diese Kombination aus modernster Hardware und Software legt das Fundament für beispiellose KI-Supercomputing-Performance.

| HGX B300 | HGX B200 | |

|---|---|---|

| Formfaktor | 8× NVIDIA Blackwell Ultra SXM | 8× NVIDIA Blackwell SXM |

| FP4 Tensor Core¹ | 144 PFLOPS | 108 PFLOPS | 144 PFLOPS | 72 PFLOPS |

| FP8/FP6 Tensor Core² | 72 PFLOPS | 72 PFLOPS |

| INT8 Tensor Core² | 3 POPS | 72 POPS |

| FP16/BF16 Tensor Core² | 36 PFLOPS | 36 PFLOPS |

| TF32 Tensor Core² | 18 PFLOPS | 18 PFLOPS |

| FP32 | 600 TFLOPS | 600 TFLOPS |

| FP64 / FP64 Tensor Core | 10 TFLOPS | 296 TFLOPS |

| Gesamtspeicher | 2,1 TB | 1,4 TB |

| NVIDIA NVLink | Fünfte Generation | Fünfte Generation |

| NVIDIA NVLink Switch™ | NVLink 5 Switch | NVLink 5 Switch |

| NVLink GPU-zu-GPU Bandbreite | 1,8 TB/s | 1,8 TB/s |

| Gesamt-NVLink-Bandbreite | 14,4 TB/s | 14,4 TB/s |

| Netzwerk-Bandbreite | 1,6 TB/s | 0,8 TB/s |

| Attention Performance³ | 2× | 1× |